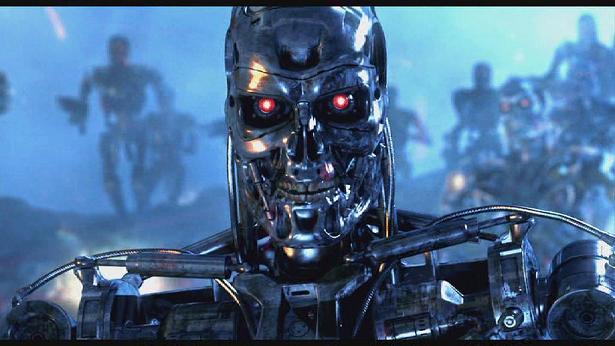

Trí thông minh nhân tạo nguy hiểm tương đương vũ khí hạt nhân

Mới đây, Stuart Russell, một Giáo sư đầu ngành trong lĩnh vực nghiên cứu trí tuệ nhân tạo cũng khẳng định: Sự nguy hiểm của trí tuệ nhân tạo tương đương với vũ khí hạt nhân.

Giáo sư Stuart Russell, một nhà nghiên cứu khoa học máy tính tại Đại học California, là một trong những người đi tiên phong trong lĩnh vực trí tuệ nhân tạo. Russell đồng thời cũng là một thành viên của Trung tâm nghiên cứu nguy cơ tuyệt chủng tại Đại học Cambridge. Ông tỏ ra khá lo ngại khi trí tuệ nhân tạo có thể được quân đội khai thác dễ dàng để trở thành một loại vũ khí.

Sự phát triển nhanh chóng trong lĩnh vực trí tuệ nhân tạo tại Boston Dynamic (mới đây đã bị Google mua lại ) nhằm phát triển các robot tự động dành cho quân đội. Ông lo ngại rằng công nghệ này có thể nguy hiểm tương đương vũ khí hạt nhân. Nếu vậy, nhân loại dường như đang lao gần hơn đến vực thẳm.

Trước đó, chúng ta đã được nghe những lời cảnh báo về nguy cơ của trí tuệ nhân tạo đến từ Elon Musk, nhà sáng lập SpaceX. Giáo sư vật lý lý thuyết Stephen Hawking cũng tham gia một nhóm các chuyên gia hàng đầu ký một bức thư ngỏ cảnh báo về sự cần thiết của những chế tài kiểm soát, hướng trí tuệ nhân tạo đến những tác động tích cực với nhân loại.

Elon Musk viết trên Twitter của mình, trí thông minh nhân tạo nguy hiểm hơn cả vũ khí hạt nhân

Trong một buổi phỏng vấn chuyên đề đặc biệt về trí tuệ nhân tạo của tạp chí Science, Stephen Hawking nói rằng: “Ngay từ đầu, công nghệ hạt nhân được định hướng sẽ là thứ mang đến cho con người nguồn năng lượng vô tận. Tuy nhiên về sau chúng lại chứng tỏ khả năng để trở thành một loại vũ khí. Tôi nghĩ rằng có một mối liên quan giữa sự vô hạn của năng lượng và sự không giới hạn của trí thông minh. Cả hai dường như đều rất tuyệt vời cho đến khi một ai đó nhìn thấy được những rủi ro của chúng.”

Các luật lệ liên quan đến vũ khí hạt nhân có thể được đặt ra khi kiểm soát được các nguồn tài nguyên như các nhà máy hạt nhân hay nguồn cung nguyên liệu phóng xạ. Trong khi đó đối với trí tuệ nhân tạo, chúng ta có thể sẽ gặp những rắc rối lớn nếu muốn kiểm soát các phần mềm.

Tuần trước, tạp chí Science đã công bố một loạt các bài báo khoa học nêu bật sự tiến bộ mà các nhà khoa học đã đạt được trong việc phát triển trí tuệ nhân tạo. Một trong số các bài báo chỉ ra khả năng ra quyết định kinh tế của máy tính mà không cần sự can thiệp của con người. Một bài báo khác nói về việc các máy tính đang tự học từ “big-data” như thế nào.

Giáo sư Russell cảnh báo rằng cần phải có những đánh giá rủi ro và các quy định nhằm kiểm soát sự nghiên cứu trí tuệ nhân tạo. Ông nhắc lại những gì Leo Szilard đã viết năm 1939 sau khi hoàn thành một chuỗi phản ứng hạt nhân: “Chúng tôi tắt tất cả các thiết bị và về nhà. Đêm đó, trong tâm trí tôi có rất ít nghi ngờ về nỗi đau mà nhân loại sắp phải gánh chịu”.

Tháng 4 vừa rồi, Giáo sư Russell đã lên tiếng bày tỏ quan ngại tại một cuộc họp của Liên Hợp Quốc tại Geneva về mối nguy hiểm khi đặt các máy bay quân sự và vũ khí dưới sự kiểm soát của một hệ thống trí thông minh nhân tạo. “Đối với những ai nói rằng chẳng vấn đề gì đâu, chúng sẽ không bao giờ đạt đến một cấp độ suy nghĩ như con người hay một siêu trí tuệ nhân tạo. Tôi sẽ trả lời họ rằng điều đó chẳng khác nào lái xe thẳng đến một vách đá và hi vọng rằng chiếc xe sẽ hết xăng kịp thời”.

Theo đề xuất của Russell, các nhà khoa học máy tính cần phải xem xét kỹ lại các mục tiêu nghiên cứu và sửa đổi nếu điều này là cần thiết. Chúng ta cần đảm bảo các giá trị và mục tiêu của con người trong sự phát triển của trí tuệ nhân tạo. Các sinh viên cần phải được đào tạo để xử lý các tình huống sự cố với trí thông minh nhân tạo giống như cách họ đang được đào tạo trong việc xử lý rò rỉ phóng xạ trong các phản ứng nhiệt hạch.

Trong một bài xã luận trên tạp chí Science, các biên tập viên Jelena Stajic, Richard Stone, Gilbert Chin và Brad Wible cũng góp tiếng nói của mình về vấn đề này: “Những gì mà trí tuệ nhân tạo đã đạt được gần đây đặt ra những câu hỏi rằng khi nào thì chúng ta khiến khoa học viễn tưởng ngày nay trở thành khoa học thật sự. Làm sao để đảm bảo rằng những cỗ máy mới nổi lên sẽ hoàn toàn nghe lời. Thế giới sẽ trở nên như thế nào nếu những chiếc máy tính thực sự thông minh sống bên cạnh con người chúng ta.”

Nói tóm lại, khi ngày càng nhiều nhân vật uy tín lên tiếng về mối nguy hiểm của việc trí tuệ nhân tạo đang được phát triển một cách nhanh chóng và không có kiểm soát. Chính chúng ta cũng bắt đầu phải tự suy nghĩ về những gì có thể xảy ra trong tương lai. Như những gì Russell so sánh, tốt nhất hãy bắt đầu cảnh giác với những con đường sai lệch giống cách mà chúng ta phát triển công nghệ hạt nhân trong thế kỷ 20.